Instrumentation des ouvrages et des installations aidant, les outils de télégestion et de supervision dédiés au domaine de l’eau doivent gérer et traiter une masse de données de plus en plus importante, transformer cette masse indifférenciée en informations intelligibles et distribuer cette dernière au bon endroit. Augmenter indéfiniment les capacités de calcul à technologie comparable ne va pas suffire, tout au moins pour les gros opérateurs. D’où l’émergence chez les éditeurs de logiciels de réflexions sur de nouvelles architectures systèmes, voire de nouveaux modèles économiques.

.jpg)

C’est en ce sens que la société Elutions a complètement repensé sa plateforme de supervision ControlMaestro en créant une nouvelle plateforme MaestroImperium™ qui utilise les dernières technologies et qui se veut capable de supporter la charge et le stress endurés par le système. Repoussant ainsi les limites logicielles, la collecte des variables se fait de manière quasiment illimitée et ininterrompue. Prévue pour début 2020, MaestroImperium est déjà en phase d’essai pilote chez un important client dans le domaine du traitement et de la distribution des eaux propres et usées.

Quelle que soit la cause, d’ailleurs pas forcément unique, de cette inflation, le résultat est le même. Un système de supervision, même affecté à un seul site ou réseau, peut aujourd’hui avoir à stocker et traiter plusieurs dizaines de milliers de variables, voire beaucoup plus chez les grands acteurs de l’eau. « Nous répondons actuellement à plusieurs appels d’offres chez de gros exploitants traitant plusieurs millions de variables pour l’ensemble de leurs clients. Ca représente plusieurs milliards d’enregistrement par an ! » souligne ainsi Gilles Nguyen, directeur Business Development chez IT Mation, éditeur de logiciels industriels, dont la plateforme de supervision Ignition.

.jpg)

« Nous ressentons que les acteurs du monde de l’eau basculent de plus en plus d’un mode local pour passer à un mode plus centralisé, analyse de son côté Michael Delaroche, Directeur commercial chez Technilog. Il y a une réelle demande d’hypervision de l’ensemble de leurs sites et un fort besoin de mobilité, c’est-à-dire la capacité de l’éditeur à fournir un accès à l’information à n’importe quel moment. Cela se traduit concrètement par la capacité qu’aura le client à naviguer agilement entre une tablette, un pc et un smartphone ».

Outre leur quantité croissante, c’est l’hétérogénéité des données qu’il faut aujourd’hui savoir prendre en compte. Les équipements et systèmes présents dans les installations n’ont en effet pas tous évolué de manière cohérente, et la supervision doit “avaler” tout cela. « On nous demande de plus en plus de nous interfacer avec des produits divers et variés avec lesquels nous n’avions pas l’habitude de nous interconnecter, et avec de nouveaux modes de communication comme LoRa ou Sigfox » souligne ainsi Arnaud Judes. « La production des données a évolué, ne serait-ce qu’avec l’essor récent de l’IoT, en particulier dans le domaine de l’eau pour le comptage. Un SCADA va donc devoir traiter des données IoT, des données d’automatismes provenant des automates de la STEP, d’autres issues de la télégestion (stations de pompage, relevage, etc.). Chaque “silo” a son propre mode de communication et de représentation, mais on nous demande désormais de tout traiter et restituer en un seul point, dans un environnement homogène », complète Gilles Nguyen.

Récupérer et transmettre les données de provenances diverses

Pour répondre à cette hétérogénéité des données et aux capacités très variables des équipements à les faire “remonter”, les éditeurs développent en général des “aspirateurs à données”, ou data pushers. Ces dispositifs logiciels et/ou matériels peuvent récupérer des données d’un appareil quelconque, même analogique, les formater et les transmettre à la supervision. Aquassay a par exemple développé le boîtier électronique Opwee, chargé de la collecte des données. « Nous avons parfois affaire à des machines un peu anciennes, incompatibles avec le Cloud. Opwee récupère leurs données, les formate et les envoie sur le Cloud » explique Vincent Reynaud. De même, chez Areal, Topkapi 6.0 offre d’ores et déjà des solutions pour cela. La prochaine version, qui verra le jour dans les mois à venir, accentuera encore cet aspect d’interopérabilité. « Selon les fabricants d’équipements avec lesquels nous collaborons, nous développons l’acquisition par e-mail, par Sigfox ou par MQTT » énumère Arnaud Judes, chez Areal. « Nous disposons actuellement d’environ 200 pilotes permettant de communiquer avec tous les équipements, mais la standardisation est en marche : il y a de moins en moins de protocoles propriétaires. C’est pourquoi MaestroImperium démarrera avec une dizaine de pilotes de base couvrant plus de 90 % du marché » précise de son côté Hervé Combe, responsable R&D d’Elutions. Copa Data affirme pour sa part disposer de plus de 300 drivers.

.jpg)

IT Mation a choisi une autre option : “délocaliser” une partie du SCADA, avec Ignition Edge. « Il s’agit de placer les composantes d’acquisition d’Ignition directement dans des calculateurs terrain. On passe ainsi d’une application en mode polling (Modbus, par exemple) à un protocole IoT, ici MQTT. Ce “calcul de bordure de réseau” (edge computing), relativement nouveau dans le domaine de l’eau, s’exécute plutôt sur ordinateurs que sur automates. L’Edge Computing règle les problèmes de latence de réseau, de bande passante et de sécurité. C’est donc une nouveauté à la fois matérielle et logicielle » expose Gille Nguyen. Bouygues Energie & Services, par exemple, a choisi Ignition comme base d’une application de supervision pour le compte du Syndicat intercommunal d’Assainissement du BREDA, près de Grenoble.

Les données hétérogènes ainsi caractérisées remontent de façon homogène (aux standards informatiques et IoT tels Web services RESTful, MQTT,…) vers la plateforme interopérable IoT et de monitoring appelé KIWI, véritable agrégateur d’échanges de données caractérisées et de services. Le SCADA traditionnel évolue vers un véritable système d’échange de données (web évolutif) pour offrir de nouveaux services. A partir de sa base de données SQL, KIWI offre plusieurs services multi métier tels le comptage des consommations, l’accès, le monitoring, la maintenance, le traitement des données.

Elutions a déjà adressé ce défi auprès de ses clients avec sa plateforme d’Intelligence Artificielle, Maestro. Maestro s'intègre parfaitement aux systèmes et infrastructures clients existants, créant ainsi un réseau de neurones fusionnant l’Intelligence Artificielle formée sur le domaine avec l’automatisation opérationnelle et des processus continus de vérification-retour et de notification pour (i) établir des prévisions opérationnelles, (ii) effectuer des ajustements opérationnels et des ordres de travail, et (iii) vérifier leur impact en temps réel, en optimisant de manière prédictive et continue la fiabilité de l'offre, l'efficacité, la capacité, la qualité, le rendement et la marge.

Selon Christopher Voss, PDG d'Elutions France, « Alors que les technologies des plateformes SCADA doivent évoluer en permanence pour prendre en charge les avancées en matière de systèmes de contrôle opérationnel, d'interopérabilité homme-machine et d'acquisition de données, la prochaine étape de l'évolution des systèmes d'entreprise consistera à institutionnaliser les plates-formes d'IA avec des technologies d'apprentissage automatique capables de traiter des millions de points de données complexes reliés instantanément - quelque chose qu'aucun humain n'est capable de faire. Une plateforme d'Intelligence Artificielle correctement formée, axée sur l'optimisation des avantages de la chaîne de valeur dans l'ensemble de l'organisation (production, maintenance, inventaire, approvisionnement, approvisionnement, etc.) deviendra un axe stratégique pour toutes les organisations complexes utilisant des données de manière intensive ».

En amont et parallèlement à la supervision, les solutions se développent…

.jpg)

Développé sur plusieurs sites pilotes avec le concours d’exploitants de manière à répondre de la façon la plus précise possible à leurs besoins, l’outil prend la forme d’une application disponible en mode SAAS. « Cette application est accessible via un simple abonnement et ne nécessite aucun investissement d’aucune sorte », souligne David Gotte, directeur commercial chez FluksAqua. L’offre démarre avec des tableaux de bord très simples sur un périmètre réduit à partir de 25 à 30 euros par mois, et s’élargit ensuite en fonction de la dimension du réseau considéré. « Ces formules diversifiées permettent de proposer à chaque exploitant un outil adapté à ses besoins, compte tenu de son réseau, de son degré d’équipement, et ceci sans qu’il n’ait besoin ni d’investir, ni de changer de matériel, explique David Gotte. Et contrairement aux logiciels standards ou aux applications spécifiques, notre application n’implique aucune modification ni intervention sur l’outil informatique de l’exploitant ». Sa mise en œuvre est simple et rapide grâce à un interfaçage avec l'outil de supervision permettant de pousser les données sur FluksAqua. Des tests gratuits sont réalisables sur simple demande.

Côté télégestion, la gamme S4W de Lacroix Sofrel intègre de nombreuses fonctions métiers évitant de recourir à des programmations ou paramétrages complexes. Elle propose de nombreuses fonctions dédiées “télégestion eau” telles que : bilans de fonctionnement, automatisme postes de relevage, calendriers, report d’alarmes, liaisons intersites, horodatage des données à la source, badges… Pour faciliter l’exploitation des données gérées par le S4W en local ou à distance, les exploitants disposent de deux interfaces de consultation graphique. S4-Display, un afficheur couleur tactile et intégrable en face avant d’armoire électrique permet la visualisation de synoptiques, de données et de courbes sur site. Totalement “plug and play”, il n’y a rien à paramétrer. S4-View est un logiciel sous environnement Windows pour consulter les données gérées par S4W. Il permet également le diagnostic de ses équipements à distance et propose de nombreux tableaux de bord.

.jpg)

Les produits Tbox, commercialisés par IP Systèmes, assurent également toutes les fonctionnalités classiques de la télégestion, comme l’enregistrement des événements, la gestion des alarmes, la multi-communication et l’interfaçage avec tout type de poste local. Les logiciels de configuration embarquent tous les outils nécessaires à la création des fonctionnalités souhaitées sans demander à l’utilisateur une quelconque spécialisation en informatique. Quelques “clics” permettent de définir, sans possibilité d’erreur, l’ensemble de ces fonctions autrefois lourdes et laborieuses à programmer dans le monde des automates programmables industriels.

.jpg)

Les traiteurs d’eau s’y mettent également. L’offre Bluwell, développée par BWT avec le concours d’Aquassay, en est une bonne illustration. Elle permet de s’interfacer avec différents types de capteurs et d’analyseurs, avec pour mission de récupérer les données pour une restitution en temps réel sous forme élaborée, permettant une maintenance préventive sur la boucle d’eau et ses équipements.

Stocker et traiter

.jpg)

connecté à Internet.

Hervé Combe de la société Elutions rapporte de son côté que « les clients nous demandent de plus en plus d’exporter les données vers des bases SQL, soit locales, soit sur Cloud soit dans des data centers, pour archivage ». Aussi, dans la nouvelle plateforme d’Elutions, les données arrivantes sont gérées par un “service” : le Data Manager pour les gérer de manière très fluide et flexible. « Nous pouvons stocker toutes les données dans une seule grosse base, soit les séparer. Dans le domaine de l’eau, nous voyons les deux types d’option. Un de nos gros clients a choisi de tout centraliser et l’autre de séparer les données “eaux usées” et “eau potable” » révèle Lydia Cobo.

Même son de cloche chez Areal : « si l’on veut garder les données à long terme, il faut leur consacrer un serveur différent de celui de la supervision. Les bases de données du type SQL Server ou ORACLE sont exigeantes en terme de ressources informatiques. Nous les mettons “à part” et elles sont interfacée via un réseau Ethernet » révèle Arnaud Judes.

Redistribuer l’information

.jpg)

IT Mation propose ainsi deux outils de présentation des données, générant dynamiquement des IHM fonctionnelles et 100 % Web, c’est à dire sans déploiement. Ignition Vision, classique de la supervision, est adapté au centre de contrôle. C’est un système de type RDA (Rich Desktop Application). Ignition Perspective, commercialisé à partir d’avril, est destiné aux agents de terrain. « On utilise le html5 responsive qui s’adapte des navigateurs de bureau aux tablettes et smartphones. Ignition Perspective permet le pilotage avec la même sécurité et les mêmes performances qu’un client lourd », précise Gilles Nguyen. Déjà déployée par l’Institution interdépartementale du bassin de la Sèvre Niortaise (IIBSN), cette solution reprend les bases de données existantes.

« Nos clients intégrateurs, distributeurs ou exploitants du monde de l’eau souhaitent principalement visualiser ou analyser leurs données pour leurs besoins, mais bien souvent, la redistribution de la donnée vers leurs propres clients est trop complexe, estime Michael Delaroche chez Technilog. C’est dans ce cadre-là qu’interviennent Web I/O, pour le Saas, et Dev I/O, pour l’acquisition, capables de mettre à disposition la donnée ou de la renvoyer vers d’autres SCADA comme Ignition d’IT Mation. Ce fut le cas par exemple pour le projet BREda. Il y a également la possibilité de redistribuer cette donnée vers des outils GMAO, d’intervention ou de facturation. Une donnée pouvant être pertinente pour plusieurs acteurs, il est très important pour nous de faciliter sa transmission et sa distribution pour donner plus de visibilité aux clients finaux sur la gestion de leur parc ».

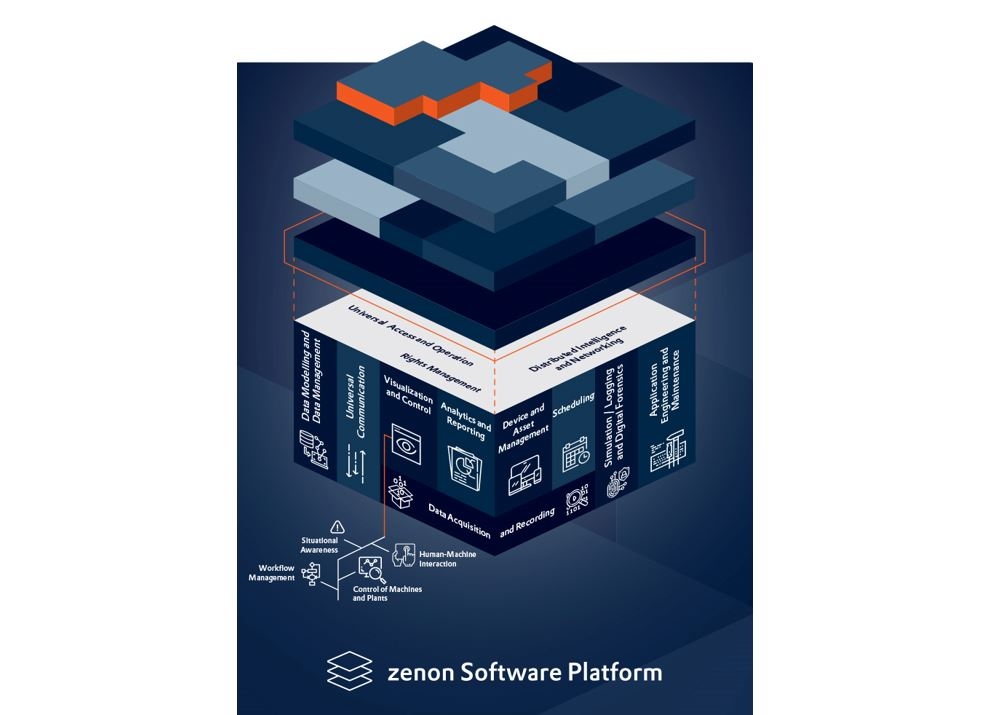

Nouvelles architectures système

.jpg)

La nouvelle plateforme MaestroImperium d’Elutions reprend pour sa part les principes du Web. « Du fait de son fonctionnement en mode “Service”, le système fournit un système de briques pour construire de manière très modulaire et flexible une architecture optimisée répondant aux problématiques IT et à ses préoccupations, notamment en termes de sécurité. Le Service central qui gère tous les autres services se lance automatiquement au démarrage comme un service Windows le prémunissant des attaques extérieures. Chargé de la communication entre les différents “Services” (collecte, stockage, planification, reporting) du système, il garantit l’équilibrage des charges si l’un des services venait à saturer à cause de l’afflux et/ou traitement des données, évitant ainsi les interruptions de services. Les connexions entre services sont protégées, passant par un réseau dédié. Tous les utilisateurs peuvent se connecter en http ou https pour accéder aux données de supervision, exactement comme avec une interface Web et un serveur dédié », explique Hervé Combe.

Cloud, data centers, SaaS : une évolution inéluctable ?

Les experts du Smart Operation Center de Suez supervisent ainsi au quotidien les infrastructures informatiques et télécoms des 4 millions de compteurs d’eau communicants en France et à l’international. Ils ont pour vocation de garantir leur performance et la restitution d’informations fiables et actualisées à leurs clients internes (centres Visio de Suez en France, données des clients régies, bailleurs, etc.). Cette vision globale permet de détecter au plus tôt tout incident, d’en alerter les exploitants et les accompagner dans l'utilisation et l’analyse des données issues des solutions de compteurs communicants. Les experts du Smart Operation Center travaillent au quotidien à l’amélioration continue des solutions en validant directement auprès des exploitants les nouveautés ou améliorations proposées. En lien direct avec les centres de pilotage régionaux VISIO, il joue un rôle de “back office” en assurant la fiabilité des données sur un territoire donné et planifier les interventions nécessaires au bon fonctionnement des systèmes de télérelève. L'intelligence opérationnelle se situe dans les VISIO. Le Smart Operation Center garantit la performance des infrastructures Smart.

« Sur une architecture distribuée incluant de l’Edge Computing. La pile technique d’Ignition est compatible avec la virtualisation, le cloud et même la containerisation » affirme pour sa part Gilles Nguyen, pour IT Mation. « L’agilité d’Ignition permet de passer très simplement d’une installation locale et la faire évoluer au fil de l’évolution des besoins. Nativement web depuis l’origine, la mise à l’échelle (scalabilité) permet gérer plusieurs millions de variables et servir plusieurs milliers de clients en utilisant des solutions d’équilibrage de charge (load balancing). Le choix est laissé au client de déployer la solution sur son propre datacenter ou dans le cloud », illustre Gilles Nguyen.Les gros opérateurs du marché, Veolia, Suez et Saur, tendent vers ce type de modèle distribué entre machines physiques propriétaires et Cloud.

.jpg)

Copa Data reste pour l’instant un pur éditeur. Comme les autres acteurs, la société réfléchit toutefois aux services Cloud qu’elle pourrait proposer pour renforcer son offre… sans toutefois aller jusqu’au Saas. « Nous développons des services Cloud supplémentaires plutôt que proposer notre SCADA en Saas. Par exemple, nous pourrions dispatcher l’information à différents types d’utilisateurs. Typiquement, un grand opérateur a besoin d’une supervision locale (ou globale sur différents sites) mais exploite pour le compte d’un syndicat. Ce dernier a besoin aussi d’avoir des informations : ce qui se passe, l’état du système, les performances de production. Nous développons des services Cloud pour que tout le monde puisse accéder à ces informations » explique Jérôme Follut. Copa Data développe donc des prototypes de services Cloud. « Par exemple, un opérateur exploite les installations pour le compte d’une métropole. Il a accès à une supervision standard sur le Cloud mais la métropole peut aller voir le nombre d’alarmes en cours, la production réelle, des informations complémentaires… Il faut savoir partager ces informations, avec une technologie existante (services RESTful) qui permettrait même à la métropole de les intégrer à son site web pour les publier. Par exemple, les résultats de la dernière analyse de la qualité de l’eau, qui intéressent les citoyens », détaille Jérôme Follut.

Aquassay a également résolument franchi le pas. « Nous utilisions à la base notre suite logicielle pour nous. Puis nous avons commencé à pouvoir nous interfacer avec différents types de données : automates, capteurs en direct, machine to machine. Nous avons alors décidé de commercialiser eDatamotic sous forme d’abonnement Cloud. Eventuellement, si le client a des difficultés à faire remonter la donnée, nous avons de petits produits électroniques pour cela. Finalement, le client indique le nombre de paramètres qu’il doit gérer et nous proposons un abonnement. eDatamotic est né de cette idée », explique Vincent Reynaud.